- Zuhause

- >

- Wolke

- >

- Stapelverarbeitung

- >

Stapelverarbeitung

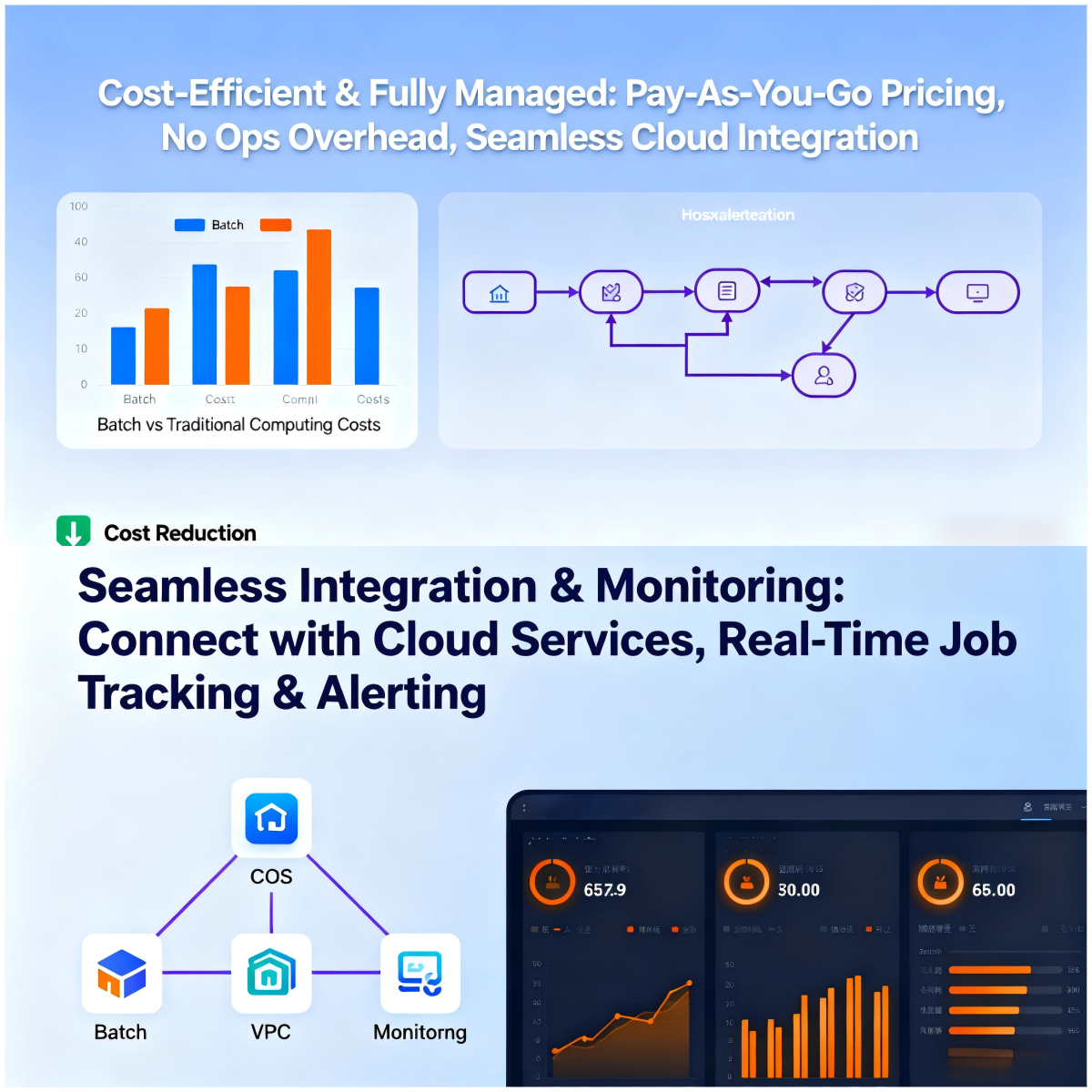

2025-12-04 17:23Tencent Cloud Batch Computing (Batch) ist eine kostengünstige, verteilte Rechenplattform für Unternehmen und Forschungseinrichtungen. Ihr Fokus liegt auf der Verarbeitung von Batch-Daten. Ob Big-Data-Batch-Verarbeitung, Batch-Verarbeitung für ML-Training oder Batch-Video-Rendering – Batch Computing bietet effiziente und stabile Rechenleistung durch intelligente Ressourcenplanung und vollständig verwaltete End-to-End-Services. Als zentrales Werkzeug für die Batch-Datenverarbeitung unterstützt Batch Computing die dynamische Konfiguration von Rechenressourcen und ermöglicht so elastische Skalierung für Big-Data-Batch-Verarbeitungsaufgaben unterschiedlicher Größenordnung. Dank der fehlenden Vorabkosten wird der Einstieg für Unternehmen deutlich erleichtert. Für die Batch-Verarbeitung im ML-Training unterstützt Batch Computing Multi-Instanz-Parallelität und die Modellierung von Aufgabenabhängigkeiten. Dies ermöglicht die schnelle Einrichtung verteilter Trainingsumgebungen und beschleunigt die Modelliteration. Im Bereich Batch-Video-Rendering erstellt Batch Computing automatisierte Rendering-Pipelines. Durch die Nutzung umfangreicher Ressourcen und Jobplanungsfunktionen führt Batch Computing die Batch-Datenverarbeitung für die visuelle Erstellung effizient durch. Batch Computing ist tief in Cloud-Services wie Object Storage (COS) integriert und bildet so einen geschlossenen Kreislauf von der Datenerfassung über die Rechenausführung bis zur Ergebnisspeicherung. Dadurch können sich die Anwender auf die Kerndatenverarbeitung und -analyse konzentrieren, ohne sich Gedanken über Ressourcenmanagement und Umgebungsbereitstellung machen zu müssen. Dies macht es zur bevorzugten Lösung für Szenarien wie Big-Data-Batchverarbeitung, Batchverarbeitung für ML-Training und Batch-Videorendering.

Häufig gestellte Fragen

F: Wie kann Batch Computing als zentrale Plattform für die Stapelverarbeitung von Daten gleichzeitig und effizient die beiden unterschiedlichen Anforderungen der Stapelverarbeitung von Big Data und des Stapel-Video-Renderings unterstützen?

A: Batch-Computing eignet sich dank flexibler Ressourcenplanung und vollständig verwalteter End-to-End-Funktionen optimal für die Anforderungen beider Arten der Batch-Datenverarbeitung. Für die Big-Data-Batch-Verarbeitung unterstützt es die dynamische und elastische Skalierung von Rechenressourcen in Kombination mit Speichereinbindungsfunktionen. Dies ermöglicht den schnellen Zugriff auf massive Datensätze und erfüllt die hohen Anforderungen an die Parallelverarbeitung im Terabyte-/Petabyte-Bereich. Für das Batch-Video-Rendering kann Batch-Computing die Bearbeitung von DAG-Workflows nutzen, um Rendering-Abhängigkeitspipelines zu erstellen. In Verbindung mit der parallelen Ausführung auf mehreren Instanzen werden so umfangreiche Rendering-Aufgaben effizient bewältigt. Dank der vollständig verwalteten Natur des Batch-Computings benötigen beide Arten der Batch-Datenverarbeitung keine manuelle Unterstützung bei der Erstellung und Freigabe von Ressourcen. Ob komplexe Datenoperationen der Big-Data-Batch-Verarbeitung oder rechenintensive Aufgaben des Batch-Video-Renderings – beides lässt sich kostengünstig und hocheffizient durchführen und der Kernnutzen des Batch-Computing voll ausschöpfen.

F: Was sind die Hauptvorteile der Batch-Verarbeitung für das ML-Training? Kann sie auch die Effizienzanforderungen der Big-Data-Batch-Verarbeitung erfüllen?

A: Die Kernvorteile von Batch Computing für die Stapelverarbeitung im ML-Training lassen sich in drei Punkten zusammenfassen: Erstens unterstützt es die Modellierung von Aufgabenabhängigkeiten und ermöglicht so eine flexible Orchestrierung von Trainings-Workflows, die sich an die mehrstufigen Anforderungen der Stapelverarbeitung im ML-Training anpassen. Zweitens kann die elastische Ressourcenskalierung die Anzahl der Instanzen dynamisch an den Umfang der Trainingsaufgabe anpassen und so Ressourcenverschwendung vermeiden. Drittens erleichtert die tiefe Integration mit Cloud-Speicher den Zugriff auf Trainingsdaten und Modelldateien. Gleichzeitig erfüllen diese Vorteile auch die Effizienzanforderungen der Big-Data-Stapelverarbeitung: Die Multi-Instanz-Parallelität von Batch Computing steigert die Verarbeitungsgeschwindigkeit von Big Data, und die Speichereinbindungsfunktion gewährleistet den effizienten Zugriff auf große Datensätze. Dadurch wird Batch Computing zu einer All-in-One-Plattform, die sowohl die Stapelverarbeitung im ML-Training als auch die Big-Data-Stapelverarbeitung unterstützt und die Vielseitigkeit ihrer Stapelverarbeitungsfunktionen unterstreicht.

F: Wie können Unternehmen, die sowohl Batch-Video-Rendering als auch Big-Data-Batch-Verarbeitung durchführen, durch Batch-Computing eine Kostenoptimierung und Prozessvereinfachung erreichen?

A: Batch Computing unterstützt Unternehmen bei der Kostenoptimierung und Prozessvereinfachung durch einen zweistufigen Mechanismus. Hinsichtlich der Kosten ermöglicht Batch Computing eine nutzungsbasierte Abrechnung, indem CVM-Instanzen nur während der Batch-Datenverarbeitung erstellt und nach Abschluss der Aufgaben automatisch gelöscht werden. Diese fehlenden Vorabkosten reduzieren die Grundkosten sowohl für die Batch-Verarbeitung von Big Data als auch für das Batch-Video-Rendering. Gleichzeitig stellt die dynamische Ressourcenkonfiguration sicher, dass die Ressourcen exakt den Aufgabenanforderungen entsprechen und Leerlaufzeiten vermieden werden. Bezüglich der Prozesse bietet Batch Computing eine ausgefeilte Aufgabendefinitionsfunktion, die eine schnelle Konfiguration von Rechenumgebungen und Ausführungsbefehlen ohne manuelle Bereitstellung ermöglicht. Für die Pipeline-Anforderungen des Batch-Video-Renderings und die komplexen Workflows der Big-Data-Batch-Verarbeitung ermöglichen die Funktionen zur DAG-Workflow-Bearbeitung und zur Modellierung von Aufgabenabhängigkeiten eine vollständige Prozessautomatisierung. In Kombination mit der öffentlichen Befehlsbibliothek und den API-Integrationsmöglichkeiten vereinfacht es den gesamten Prozess der Batch-Datenverarbeitung von der Aufgabenübermittlung bis zur Ergebnisausgabe. Ob für die Batch-Verarbeitung im ML-Training oder andere Batch-Computing-Szenarien – es lässt sich effizient implementieren.